A inteligência artificial representa um papel importante, ao mesmo tempo em que gera debates calorosos sobre o assunto. De um lado, ela pode nos auxiliar nas tarefas mais cotidianas e simples, como por exemplo, traduzir um texto. Mas por outro lado, ao contrário do que muitos ainda imaginam, ela pode vir carregada de vieses. Há muito tempo já se discute o fato de que muitas vezes a inteligência artificial não é neutra.

Quando pensamos no quanto a tecnologia pode nos auxiliar em outros processos, como o processo seletivo de pessoas para ocupar cargos em empresas, o problema é ainda mais profundo. Podemos citar o caso da Amazon, em que o algoritmo desfavoreceu a candidatura de mulheres, por entender que mulheres possuíam menos qualificação para os cargos.

Ainda que a empresa contratada pela Amazon para seus processos seletivos tenha incluído a neutralidade de gênero, não há nenhuma garantia que o algoritmo não encontre outras maneiras de se tornar preconceituoso e excludente.

Em um mundo preconceituoso não podemos esperar que as IAs sejam neutras

O primeiro passo para um mundo com mais equidade em relação às inteligências artificiais talvez seja reconhecer que as IAs não são neutras. Isso não acontece porque a tecnologia em si tem uma natureza discriminatória, mas porque elas são programadas por pessoas, que por sua vez possuem suas próprias subjetividades.

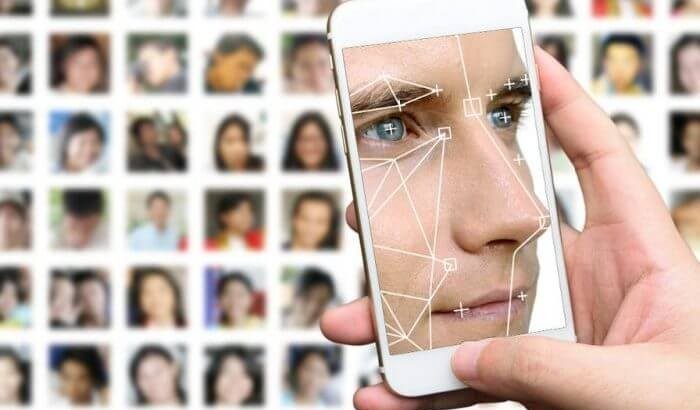

As IAs podem tanto cumprir funções objetivas, como por exemplo, recortar o fundo de uma imagem, até serem mais subjetivas, como é o caso de um processo seletivo. Entender que as duas funções são completamente distintas nos faz perceber que construir algoritmos para o funcionamento de uma IA é um processo complexo e influenciável por uma série de vieses.

Um exemplo que pode nos ajudar a perceber a complexidade das inteligências artificiais e como os vieses as afetam é a tradução de termos por ferramentas de tradução. Na língua inglesa (e também em outras línguas) não temos a diferenciação de gênero para muitos termos, incluindo para profissões.